Conversión de texto a voz para aplicaciones de chat de voz: una guía práctica para 2025

¿Qué es la conversión de texto a voz y por qué es importante en 2025?

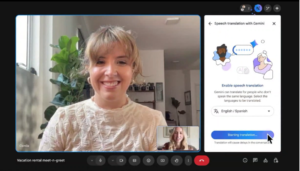

En las últimas semanas, es posible que hayas oído hablar de la impresionante nueva función de traducción de Google Meet. Mientras hablas, la otra persona recibe el audio en su propio idioma. Esta innovación, junto con otras, como la versión con función de voz de ChatGPT, se basa en la conversión de texto a voz para aplicaciones de chat de voz, un campo en rápida evolución que es fundamental para las herramientas de comunicación modernas. La tecnología de conversión de texto a voz (TTS) ha evolucionado considerablemente, transformando el texto escrito en lenguaje hablado con un realismo extraordinario. Desempeña un papel crucial en las aplicaciones de chat de voz al permitir la comunicación en tiempo real y mejorar la experiencia del usuario de múltiples maneras. Los sistemas TTS modernos admiten voces y tonos emocionales personalizados, lo que hace que las interacciones sean más atractivas y parecidas a las humanas. Además, el TTS mejora la accesibilidad al poner el contenido digital a disposición de personas con discapacidades visuales o dificultades de lectura. A medida que aumenta la dependencia de las interfaces basadas en voz, el TTS se está convirtiendo en un componente esencial de las aplicaciones innovadoras y fáciles de usar. En este blog, profundizaremos en el panorama actual de los TTS, rastrearemos su evolución y examinaremos los modelos más avanzados de la actualidad, tanto en las ofertas comerciales como de código abierto. Compararemos sus capacidades, ventajas y desventajas y opciones de implementación, centrándonos especialmente en los casos de uso en tiempo real, como el chat de voz. Además, exploraremos uno de los aspectos más importantes, pero que a menudo se pasa por alto: la implementación del TTS en dispositivos periféricos, donde los recursos limitados pueden hacer que ciertos modelos sean inviables. Al final, comprenderá claramente lo último en tecnología de TTS, los puntos fuertes y las limitaciones de los modelos más avanzados y tendrá conocimientos prácticos para elegir la solución adecuada para sus propias aplicaciones basadas en la voz, ya sea que las esté creando en la nube, en un dispositivo periférico o en algún punto intermedio.

La evolución de los sistemas de conversión de texto a voz

La tecnología de conversión de texto a voz ha sufrido una transformación notable, pasando de métodos básicos que producían voz con sonido robótico a sistemas neuronales avanzados capaces de generar voces altamente naturales y expresivas. Esta evolución se puede dividir en diferentes fases, cada una de las cuales se caracteriza por metodologías y avances tecnológicos distintos. Los primeros sistemas TTS se basaban en la síntesis concatenativa, en la que la voz se producía seleccionando y concatenando segmentos pregrabados (como fonemas o sílabas) almacenados en una gran base de datos. Más tarde, la síntesis paramétrica surgió como un enfoque más flexible, que generaba voz basada en parámetros fonéticos como el tono, la duración y la entonación. Estos modelos convertían el texto en representaciones fonéticas y sintetizaban el habla de forma dinámica, aunque con limitaciones de naturalidad y expresividad. La llegada de las redes neuronales revolucionó el TTS al permitir que los modelos aprendieran directamente de grandes conjuntos de datos, capturando los sutiles matices del habla humana, como la entonación, el ritmo y la emoción. Uno de los primeros modelos innovadores de TTS neuronal fue WaveNet, presentado por DeepMind en 2016 (parece que fue hace mucho tiempo en la época de la IA). WaveNet generó audio sin procesar muestra por muestra, produciendo una voz que imita la voz humana de forma mucho más natural que sus predecesoras. Este avance, junto con otros modelos de aprendizaje profundo como Tacotrón 2 de Nvidia y la posterior adopción del Arquitectura de transformadores, presentado por primera vez en el Transformador TTS , sentó las bases de los modelos TTS de última generación actuales, que siguen basándose en estos avances para ofrecer una voz sintética aún más realista y expresiva. En los siguientes audios, puedes escuchar el progreso de la generación del TTS: [audio mp3=» https://blog.marvik.ai/wp-content/uploads/2025/05/clasic.mp3"][/audio] Síntesis concatenativa [audio wav=» https://blog.marvik.ai/wp-content/uploads/2025/05/output_tacotron_reduced.wav"][/audio] Modelo de aprendizaje profundo Tacotron 2 [audio wav=» https://blog.marvik.ai/wp-content/uploads/2025/05/sota.wav"][/audio] Modelo de última generación: OpenAI API

Modelos TTS de última generación

El campo de la conversión de texto a voz ha alcanzado niveles de sofisticación sin precedentes, y los principales modelos actuales ofrecen niveles de realismo y flexibilidad que antes se consideraban imposibles. Ya sea que necesite un modelo para la traducción en tiempo real, asistentes de voz o aplicaciones creativas, no hay escasez de opciones. Sin embargo, con tantas opciones, es fácil sentirse abrumado. Para ayudarlo a encontrar la mejor opción para su proyecto, es importante centrarse en algunos factores clave al comparar los modelos.

Aspectos clave de un modelo TTS

Código abierto frente a código cerrado Los modelos de código abierto ofrecen funciones de transparencia, personalización y autohospedaje, que son importantes si trabajas con información personal confidencial. Las API de código cerrado ofrecen facilidad de uso y escalabilidad, pero menos flexibilidad y control sobre el modelo subyacente. Un cambio inesperado en un modelo por parte del proveedor puede afectar a su aplicación. ¿Cuánto control necesitas? Algunos modelos permiten un control detallado de las emociones, la entonación y el estilo de habla mediante parámetros o etiquetas, como el parámetro de exageración de las emociones de Chatterbox o las instrucciones de estilo lingüístico de OpenAI, mientras que otros ofrecen salidas de voz más fijas. Rendimiento en tiempo real (latencia) Para aplicaciones como el chat de voz o la traducción en vivo, la latencia es importante. Modelos como Orpheus y Chatterbox proporcionan una latencia de alrededor de 200 ms, lo que los hace adecuados para casos de uso en tiempo real. OpenAI (~ 500 ms) y ElevenLabs (~ 400 ms) también proporcionan salidas de baja latencia adecuadas para casos de uso en tiempo real. Complejidad de integración y flexibilidad de implementación. Los modelos de código abierto como Orpheus, Dia y Chatterbox ofrecen una implementación flexible, ya sea local o en la nube. Sin embargo, ellos requieren una GPU significativa recursos (p. ej., Chatterbox ~6,5 GB de VRAM, Orpheus ~12 GB, Dia ~10 GB) y más esfuerzo de configuración. Las API de código cerrado, como ElevenLabs y OpenAI, eliminan la necesidad de un hardware dedicado y ofrecen una integración lista para usar, pero con menos control sobre la implementación. Capacidades de clonación de voz. La clonación de voz es una característica clave a tener en cuenta. Te permite personalizar y controlar las voces que se utilizan en tu aplicación. Si la personalización es una prioridad, debe evaluar si necesita una clonación de voz sin intervención o una creación de voz personalizada. Los modelos abiertos como Orpheus y Chatterbox admiten la clonación de voz a partir de un mínimo de audio, mientras que OpenAI actualmente no ofrece la clonación y ElevenLabs ofrece funciones de clonación avanzadas. Soporte multilingüe. Si necesita soporte para varios idiomas, ElevenLabs y OpenAI proporcionan sólidas capacidades multilingües listas para usar, mientras que los modelos de código abierto suelen dar prioridad al inglés, pero se pueden ajustar para otros idiomas. Rendimiento en naturalidad, expresividad y precisión. Los modelos TTS de alta calidad se evalúan tanto por su naturalidad como por su precisión. La tasa de errores de palabras (WER) mide la calidad de la transcripción, mientras que las pruebas ciegas miden la expresividad y el realismo. Chatterbox ha superado a ElevenLabs en naturalidad y CSM se destaca por captar el tono emocional. Al elegir un modelo, equilibre la experiencia auditiva con una salida clara y precisa. También debes considerar el entorno de implementación y probar el modelo con tu propio conjunto de datos. Un modelo puede funcionar bien con datos generales, pero tener problemas con los términos específicos de la industria.

Selección de la mejor opción

Teniendo en cuenta estos aspectos clave, analicemos más detenidamente cómo se comparan los principales modelos de TTS, tanto de código abierto como de código cerrado, para ayudarlo a encontrar la mejor opción para su aplicación.

Al comparar los principales modelos de TTS de código abierto, Chatterbox destaca por su equilibrio entre facilidad de uso, rendimiento y personalización. Mientras Canopy Orfeo ofrece una entonación impresionante similar a la humana y una transmisión de baja latencia, pero requiere una infraestructura más pesada y necesita al menos 12 GB de VRAM de GPU. Sésamo CSM se centra principalmente en la dinámica conversacional, pero es más específico para los casos de uso basados en el diálogo. Dia-1.6B sobresale en el diálogo con varios oradores y en la expresión no verbal, pero también exige recursos sustanciales.

Desde el punto de vista del código cerrado, Once laboratorios sigue liderando con sus funciones de generación de voz altamente realistas, clonación de voz y doblaje avanzado con IA. Es compatible con 29 idiomas y proporciona tiempos de respuesta de API rápidos (aproximadamente 400 ms), lo que la convierte en la opción ideal para las empresas que necesitan soluciones de voz multilingües y escalables. API de audio de OpenAI también es un buen reproductor, ya que ofrece salidas expresivas de baja latencia y un fácil control de estilo mediante instrucciones en lenguaje natural. Sin embargo, carece de clonación de voz, lo que limita la personalización de aplicaciones en las que la personalización de la marca o del usuario es clave.

Teniendo en cuenta todos estos aspectos, desde el control del estilo de voz y las emociones, el rendimiento en tiempo real, la flexibilidad de implementación, el soporte multilingüe y las capacidades de clonación de voz. Chatterbox se perfila como la mejor alternativa de código abierto, ya que ofrece una voz expresiva y de alta calidad con control de emociones, clonación de voz sin disparos y marcas de agua perceptivas, a la vez que mantiene unos requisitos de VRAM relativamente bajos (~6,5 GB). En las pruebas a ciegas, los oyentes incluso prefirieron sus productos a los de ElevenLabs. Puedes probarlo tú mismo, ya que es fácil de usar. Demostración de Hugging Face. Para quienes buscan una solución de código cerrado lista para usar con sólidas capacidades multilingües y de clonación, ElevenLabs sigue siendo la mejor opción.

Pruebe siempre los modelos con sus propios datos y vocabulario para garantizar los mejores resultados. A continuación, puedes escuchar la extraordinaria clonación de voz sin disparos de Chatterbox utilizando solo un breve audio de referencia:

[audio ogg=» https://blog.marvik.ai/wp-content/uploads/2025/06/input_chatterbox.ogg"][/audio] Audio de voz de referencia [audio wav=» https://blog.marvik.ai/wp-content/uploads/2025/06/chatterbox2.wav"][/audio] Salida TTS de Chatterbox

Implementación perimetral de modelos TTS para aplicaciones de chat de voz

En la sección anterior, exploramos los modelos actuales de TTS de última generación, tanto de código abierto como cerrado. Sin embargo, la implementación de estos modelos en dispositivos periféricos, como teléfonos, sistemas integrados o asistentes sin conexión a Internet, requiere una reconsideración cuidadosa de las opciones. Los entornos periféricos presentan restricciones únicas que difieren significativamente de las implementaciones basadas en la nube. En primer lugar, los dispositivos periféricos funcionan con estrictas limitaciones de recursos. A diferencia de la nube, los entornos periféricos tienen límites fijos en cuanto a memoria, potencia de cálculo y energía. Las actualizaciones y el escalado no son tan fáciles de administrar. Esto hace que la eficiencia del modelo sea un factor crítico. Además, el TTS es solo un componente de un sistema completo de chat de voz. Como se muestra en esta figura, una canalización típica incluye:

- conversión de voz a texto para transcribir la voz del usuario,

- Un modelo de lenguaje amplio (LLM) para interpretar y generar una respuesta,

- Conversión de texto a voz para sintetizar la respuesta en audio.

[caption id="attachment_4515" align="aligncenter» width="788"]

Diagrama de alto nivel de una aplicación de chat de voz a voz [/caption] Incluso con los avances recientes en los LLM ligeros mediante técnicas como modelo de destilación y la cuantificación, el modelo lingüístico sigue siendo el componente que consume más recursos. Como resultado, solo una pequeña parte de los recursos informáticos puede ir a TTS. Esto dificulta la ejecución de modelos de alta calidad en dispositivos periféricos. Evaluemos las opciones analizadas anteriormente a la luz de estas restricciones:

- Las API de código cerrado (por ejemplo, ElevenLabs) necesitan acceso constante a Internet y servidores externos. Con frecuencia, estas condiciones no están disponibles o no son ideales para la implementación perimetral.

- Los modelos de última generación de código abierto, como Canopy Orpheus y Sesame CSM, ofrecen una calidad de voz excepcional, pero consumen demasiados recursos. Orpheus, por ejemplo, necesita al menos 12 GB de VRAM en la GPU. CSM y Chatterbox requieren alrededor de 6 GB, lo que supera lo que normalmente está disponible en el hardware periférico.

Esto nos lleva a considerar alternativas optimizadas para la implementación perimetral, incluso si sacrifican algo de fidelidad en la calidad de la voz. Uno de esos modelos es Kororo TTS, un sistema TTS ligero de código abierto con solo 82 millones de parámetros. Solo requiere 1,5 GB de VRAM en la GPU y es lo suficientemente rápido como para realizar inferencias en tiempo real. Aunque no coincide con la expresividad de Orpheus o CSM, ofrece una voz con un sonido natural adecuada para aplicaciones conversacionales. Además, viene con una biblioteca abierta y más de 20 estilos de voz preconfigurados, lo que lo hace apto para desarrolladores y fácil de integrar. En resumen, los principales modelos de TTS destacan por su realismo y matices emocionales. Sin embargo, su alta demanda de recursos los hace poco prácticos para el despliegue perimetral. Kororo TTS ofrece una alternativa atractiva, ya que logra un equilibrio entre el rendimiento, la eficiencia de los recursos y la facilidad de uso. Para las aplicaciones de chat de voz que se ejecutan en dispositivos periféricos, se destaca por ser una opción práctica y confiable.

Conclusión

A estas alturas, ya deberías tener una idea clara del panorama actual de la conversión de texto a voz. Modelos como Canopy Orpheus, Sesame CSM y Chatterbox están estableciendo nuevos estándares de naturalidad, emoción y expresividad en este campo tan cambiante. La elección de la solución correcta depende totalmente de sus necesidades y limitaciones. Esta es una guía rápida que le ayudará a decidir:

- Para dispositivos periféricos sin acceso estable a Internet, los modelos livianos como el Kororo TTS son una opción sólida. Como alternativa, puede usar versiones cuantificadas de modelos más grandes para la inferencia local.

- Si su principal prioridad es calidad de voz y tienes acceso a un Infraestructura de nube o GPU, elige modelos de código abierto de alta fidelidad como Chatterbox, CSM u Orpheus, siendo Chatterbox la mejor opción si necesitas hacer clonación de voz.

- Si necesita un amplio soporte multilingüe y desea minimizar los gastos generales de ingeniería, las API cerradas como OpenAI Audio API o ElevenLabs ofrecen soluciones listas para usar con una cobertura lingüística y un control emocional impresionantes.

Por último, tenga en cuenta que el campo de los TTS está evolucionando a un ritmo rápido. Las soluciones que son de última generación en la actualidad pueden reemplazarse o superarse en cuestión de semanas. Los avances en la destilación, la cuantificación y la eficiencia del entrenamiento facilitan la implementación del TTS en todas las plataformas. Estas mejoras llevan la síntesis de voz de alta calidad a todo tipo de aplicaciones, desde aplicaciones móviles hasta sistemas integrados.

.png)