Conversão de texto em fala para aplicativos de bate-papo por voz: um guia prático de 2025

O que é conversão de texto em fala e por que isso importa em 2025?

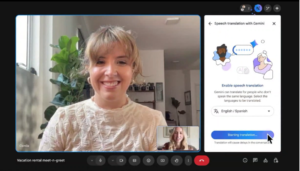

Nas últimas semanas, você deve ter ouvido falar sobre o impressionante novo recurso de tradução do Google Meet. Enquanto você fala, a outra pessoa recebe áudio em seu próprio idioma. Essa inovação, junto com outras, como a versão habilitada por voz do ChatGPT, é alimentada por conversão de texto em fala para aplicativos de bate-papo por voz, um campo em rápida evolução no centro das ferramentas de comunicação modernas. A tecnologia de conversão de texto em fala (TTS) evoluiu significativamente, transformando texto escrito em linguagem falada com realismo notável. Ele desempenha um papel crucial nos aplicativos de bate-papo por voz, permitindo a comunicação em tempo real e aprimorando a experiência do usuário de várias maneiras. Os sistemas TTS modernos suportam vozes personalizadas e tons emocionais, tornando as interações mais envolventes e humanas. Além disso, o TTS melhora a acessibilidade ao disponibilizar conteúdo digital para pessoas com deficiência visual ou dificuldade de leitura. À medida que a dependência de interfaces baseadas em voz continua a crescer, o TTS está se tornando um componente essencial de aplicativos inovadores e fáceis de usar. Neste blog, vamos nos aprofundar no cenário atual do TTS, traçando sua evolução e examinando os modelos mais avançados da atualidade em ofertas comerciais e de código aberto. Compararemos suas capacidades, vantagens e desvantagens e opções de implantação, com um foco particular em casos de uso em tempo real, como bate-papo por voz. Além disso, exploraremos um dos aspectos mais importantes, mas muitas vezes esquecidos: implantar o TTS em dispositivos de ponta, onde recursos limitados podem tornar certos modelos inviáveis. Ao final, você terá uma compreensão clara do estado da arte em TTS, dos pontos fortes e das limitações dos principais modelos e insights práticos sobre como escolher a solução certa para seus próprios aplicativos baseados em voz, esteja você criando na nuvem, em um dispositivo de ponta ou em algum lugar intermediário.

A evolução dos sistemas de conversão de texto em fala

A tecnologia de conversão de texto em fala passou por uma transformação notável, evoluindo de métodos básicos que produziam fala com som robótico para sistemas neurais avançados capazes de gerar vozes altamente naturais e expressivas. Essa evolução pode ser dividida em diferentes fases, cada uma caracterizada por metodologias e avanços tecnológicos distintos. Os primeiros sistemas TTS dependiam da síntese concatenativa, em que a fala era produzida selecionando e concatenando segmentos pré-gravados (como fonemas ou sílabas) armazenados em um grande banco de dados. Posteriormente, a síntese paramétrica surgiu como uma abordagem mais flexível, gerando fala com base em parâmetros fonéticos como tom, duração e entonação. Esses modelos converteram texto em representações fonéticas e sintetizaram dinamicamente a fala, embora com limitações de naturalidade e expressividade. O advento das redes neurais revolucionou o TTS ao permitir que os modelos aprendam diretamente de grandes conjuntos de dados, capturando as nuances sutis da fala humana, incluindo entonação, ritmo e emoção. Um dos primeiros modelos neurais inovadores de TTS foi WaveNet, introduzido pela DeepMind em 2016 (parece muito tempo atrás na época da IA). O WaveNet gerou áudio bruto amostra por amostra, produzindo uma fala que imita a voz humana com muito mais naturalidade do que seus antecessores. Essa inovação, junto com outros modelos de aprendizado profundo, como Tacotron 2 da Nvidia e a posterior adoção do Arquitetura do transformador, introduzido pela primeira vez no Transformador TTS modelo, lançou as bases para os modelos TTS de última geração de hoje, que continuam a se basear nesses avanços para oferecer uma fala sintética ainda mais realista e expressiva. Nos áudios a seguir, você pode ouvir o progresso da geração de TTS: [audio mp3=” https://blog.marvik.ai/wp-content/uploads/2025/05/clasic.mp3"][/audio] Síntese concatenativa [audio wav=” https://blog.marvik.ai/wp-content/uploads/2025/05/output_tacotron_reduced.wav"][/audio] Modelo de aprendizado profundo Tacotron 2 [audio wav=” https://blog.marvik.ai/wp-content/uploads/2025/05/sota.wav"][/audio] Modelo de última geração: API OpenAI

Modelos TTS de última geração

O campo da conversão de texto em fala atingiu níveis de sofisticação sem precedentes, com os principais modelos atuais oferecendo níveis de realismo e flexibilidade antes considerados impossíveis. Se você precisa de um modelo para tradução em tempo real, assistentes de voz ou aplicativos criativos, não faltam opções. Mas com tantas opções, é fácil se sentir sobrecarregado. Para ajudar você a encontrar a melhor opção para seu projeto, é importante se concentrar em alguns fatores-chave ao comparar modelos.

Aspectos principais de um modelo TTS

Código aberto versus código fechado Os modelos de código aberto oferecem recursos de transparência, personalização e hospedagem automática, que são importantes se você trabalha com informações pessoais confidenciais. As APIs de código fechado oferecem facilidade de uso e escalabilidade, mas menos flexibilidade e controle sobre o modelo subjacente. Uma mudança inesperada em um modelo feita pelo provedor pode afetar seu aplicativo. De quanto controle você precisa? Alguns modelos permitem um controle refinado sobre a emoção, a entonação e o estilo de fala por meio de parâmetros ou tags, como o parâmetro de exagero emocional do Chatterbox ou as instruções de estilo de linguagem do OpenAI, enquanto outros oferecem saídas de voz mais fixas. Desempenho em tempo real (latência) Para aplicativos como bate-papo por voz ou tradução ao vivo, a latência é importante. Modelos como Orpheus e Chatterbox oferecem latência em torno de 200 ms, o que os torna adequados para casos de uso em tempo real. O OpenAI (~ 500 ms) e o ElevenLabs (~ 400 ms) também fornecem saídas de baixa latência adequadas para casos de uso em tempo real. Complexidade de integração e flexibilidade de implantação. Modelos de código aberto, como Orpheus, Dia e Chatterbox, oferecem implantação flexível, localmente ou na nuvem. No entanto, eles exigem uma GPU significativa recursos (por exemplo, Chatterbox ~6,5 GB VRAM, Orpheus ~12 GB, Dia ~10 GB) e mais esforço de configuração. APIs de código fechado, como ElevenLabs e OpenAI, eliminam a necessidade de hardware dedicado e oferecem integração plug-and-play, mas com menos controle sobre a implantação. Capacidades de clonagem de voz. A clonagem de voz é um recurso importante a ser considerado. Ele permite que você personalize e controle as vozes usadas em seu aplicativo. Se a personalização for uma prioridade, você deve avaliar se precisa de clonagem de voz zero ou criação de voz personalizada. Modelos abertos como Orpheus e Chatterbox suportam clonagem de voz a partir do mínimo de áudio, enquanto o OpenAI atualmente não oferece clonagem e o ElevenLabs fornece recursos avançados de clonagem. Suporte multilíngue. Se você precisar de suporte para vários idiomas, o ElevenLabs e o OpenAI oferecem recursos multilíngues robustos prontos para uso, enquanto os modelos de código aberto geralmente priorizam o inglês, mas podem ser ajustados para outros idiomas. Desempenho em naturalidade, expressividade e precisão. Os modelos TTS de alta qualidade são avaliados tanto pela naturalidade quanto pela precisão. O Word Error Rate (WER) mede a qualidade da transcrição, enquanto os testes cegos avaliam a expressividade e o realismo. O Chatterbox superou o ElevenLabs em naturalidade e o CSM se destaca por capturar o tom emocional. Ao escolher um modelo, equilibre a experiência auditiva com uma saída clara e precisa. Você também deve considerar o ambiente de implantação e testar o modelo com seu próprio conjunto de dados. Um modelo pode funcionar bem em dados gerais, mas tem dificuldades com termos específicos do setor.

Selecionar a melhor opção

Com esses principais aspectos em mente, vamos examinar mais de perto como os principais modelos de TTS se comparam, tanto de código aberto quanto de código fechado, para ajudar você a encontrar a melhor opção para sua aplicação.

Ao comparar os principais modelos de TTS de código aberto, Chatterbox se destaca pelo equilíbrio entre facilidade de uso, desempenho e personalização. Enquanto Dossel Orfeu oferece uma entonação semelhante à humana impressionante e streaming de baixa latência, mas requer uma infraestrutura mais pesada, precisando de pelo menos 12 GB de GPU VRAM. CSM de gergelim traz um forte foco na dinâmica de conversação, mas é mais um nicho para casos de uso orientados por diálogos. Dia-1,6B se destaca no diálogo com vários falantes e na expressão não verbal, mas também exige recursos substanciais.

No lado do código fechado, Onze laboratórios continua liderando com sua geração de voz altamente realista, clonagem de voz e recursos avançados de dublagem de IA. Ele suporta 29 idiomas e fornece tempos de resposta de API rápidos (~ 400 ms), tornando-o uma opção ideal para empresas que precisam de soluções de voz escaláveis e multilíngues. API de áudio da OpenAI também é um player forte, oferecendo saídas expressivas e de baixa latência e fácil controle de estilo por meio de instruções em linguagem natural. No entanto, ele carece de clonagem de voz, o que limita a personalização de aplicativos em que a personalização da marca ou do usuário é fundamental.

Considerando todos esses aspectos, desde o controle sobre o estilo e a emoção da fala, desempenho em tempo real, flexibilidade de implantação, suporte multilíngue e recursos de clonagem de voz. O Chatterbox surge como a melhor alternativa de código aberto, pois oferece fala expressiva e de alta qualidade com controle de emoções, clonagem de voz sem disparos e marca d'água perceptiva, mantendo requisitos de VRAM relativamente baixos (~ 6,5 GB). Em testes cegos, os ouvintes até preferiram suas saídas em vez da ElevenLabs. Você pode experimentá-lo sozinho, é fácil de usar. Demonstração do Hugging Face. Para aqueles que buscam uma solução de código fechado, pronta para uso, com fortes recursos multilíngues e de clonagem, ElevenLabs continua sendo a melhor escolha.

Sempre teste modelos com seus próprios dados e vocabulário para garantir os melhores resultados. Abaixo, você pode ouvir a notável clonagem de voz sem disparo do Chatterbox usando apenas um breve áudio de referência:

[audio ogg=” https://blog.marvik.ai/wp-content/uploads/2025/06/input_chatterbox.ogg"][/audio] Áudio da voz de referência [audio wav=” https://blog.marvik.ai/wp-content/uploads/2025/06/chatterbox2.wav"][/audio] Saída TTS do Chatterbox

Implantação periférica de modelos TTS para aplicativos de bate-papo por voz

Na seção anterior, exploramos os modelos atuais de TTS de última geração, tanto de código aberto quanto fechado. No entanto, a implantação desses modelos em dispositivos de ponta, como: telefones, sistemas embarcados ou assistentes off-line, exige uma reconsideração cuidadosa de suas opções. Os ambientes periféricos apresentam restrições exclusivas que diferem significativamente das implantações baseadas na nuvem. Em primeiro lugar, os dispositivos de ponta operam sob estritas limitações de recursos. Diferentemente da nuvem, os ambientes periféricos têm limites fixos de memória, potência computacional e energia. Os upgrades e o dimensionamento não são tão fáceis de gerenciar. Isso torna a eficiência do modelo um fator crítico. Além disso, o TTS é apenas um componente de um sistema completo de bate-papo por voz. Conforme mostrado nesta figura, um pipeline típico inclui:

- Conversão de voz em texto para transcrever a voz do usuário,

- Um modelo de linguagem grande (LLM) para interpretar e gerar uma resposta,

- Conversão de texto em fala para sintetizar a resposta em áudio.

[caption id="attachment_4515" align="aligncenter” width="788"]

Diagrama de alto nível de um aplicativo de bate-papo de voz para voz [/caption] Mesmo com o progresso recente em LLMs leves por meio de técnicas como destilação modelo e quantização, o modelo de linguagem continua sendo o componente que mais consome recursos. Como resultado, somente uma pequena parte dos recursos de computação pode ir para o TTS. Isso dificulta a execução de modelos de alta qualidade em dispositivos de ponta. Vamos avaliar as opções discutidas anteriormente à luz dessas restrições:

- APIs de código fechado (por exemplo, ElevenLabs) precisam de acesso constante à Internet e servidores externos. Essas condições geralmente não estão disponíveis ou não são ideais para implantação periférica.

- Modelos de código aberto de última geração, como o Canopy Orpheus e o Sesame CSM, oferecem qualidade de voz excepcional, mas consomem muitos recursos. O Orpheus, por exemplo, precisa de pelo menos 12 GB de GPU VRAM. O CSM e o Chatterbox exigem cerca de 6 GB, o que excede o que normalmente está disponível em hardware de ponta.

Isso nos leva a considerar alternativas otimizadas para implantação de ponta, mesmo que elas sacrifiquem alguma fidelidade na qualidade de voz. Um desses modelos é Kororo TTS, um sistema TTS leve de código aberto com apenas 82 milhões de parâmetros. Ele requer apenas 1,5 GB de GPU VRAM e é rápido o suficiente para inferência em tempo real. Embora não corresponda à expressividade do Orpheus ou do CSM, ele oferece uma fala natural adequada para aplicações de conversação. Além disso, ele vem com uma biblioteca aberta e mais de 20 estilos de voz pré-configurados, tornando-o amigável ao desenvolvedor e fácil de integrar. Em resumo, os principais modelos de TTS se destacam em realismo e nuances emocionais. No entanto, suas altas demandas de recursos os tornam impraticáveis para a implantação de ponta. O Kororo TTS oferece uma alternativa atraente, alcançando um equilíbrio entre desempenho, eficiência de recursos e usabilidade. Para aplicativos de bate-papo por voz executados em dispositivos periféricos, ele se destaca como uma opção prática e confiável.

Conclusão

Até agora, você deve ter uma imagem clara do cenário atual de conversão de texto em fala. Modelos como Canopy Orpheus, Sesame CSM e Chatterbox estão estabelecendo novos padrões de naturalidade, emoção e expressividade nesse campo em rápida evolução. A escolha da solução certa depende inteiramente de suas necessidades e restrições. Aqui está um guia rápido para ajudar você a decidir:

- Para dispositivos de ponta sem acesso estável à Internet, modelos leves como o Kororo TTS são uma escolha sólida. Como alternativa, você pode usar versões quantizadas de modelos maiores para inferência local.

- Se sua principal prioridade é qualidade de voz e você tem acesso a um GPU ou infraestrutura em nuvem, escolha modelos de código aberto de alta fidelidade, como Chatterbox, CSM ou Orpheus, sendo o Chatterbox a melhor opção se você precisar fazer clonagem por voz.

- Se você precisar de um amplo suporte multilíngue e quiser minimizar a sobrecarga de engenharia, APIs fechadas, como a OpenAI Audio API ou a ElevenLabs, oferecem soluções prontas para uso com impressionante cobertura de idiomas e controle emocional.

Por fim, lembre-se de que o campo TTS está evoluindo em um ritmo rápido. Atualmente, as soluções de última geração podem ser substituídas ou superadas em questão de semanas. Os avanços na eficiência de destilação, quantização e treinamento estão facilitando a implantação do TTS em todas as plataformas. Essas melhorias trazem síntese de voz de alta qualidade para tudo, desde aplicativos móveis até sistemas embarcados.

.png)