.png)

IA en el espacio: combinación del aprendizaje automático con imágenes de satélite para impulsar la agricultura

Introducción

En el área de la investigación agrícola, la utilización del poder de las imágenes satelitales se ha convertido en un punto de inflexión. Estas tecnologías proporcionan información valiosa que permite a los agricultores, investigadores y profesionales de la industria tomar decisiones informadas, optimizar los recursos y maximizar el rendimiento de los cultivos. Sin embargo, trabajar con datos satelitales tiene su propio conjunto de desafíos y complejidades que debemos abordar con cuidado. Además, todos hemos sido testigos de cómo, en los últimos años, la IA se ha apoderado del mundo. Estamos, sin duda, en una época de cambios. Cada día vemos más y más aplicaciones del aprendizaje automático en todo tipo de campos. Inevitablemente, esto plantea la siguiente pregunta: ¿y si combinamos el aprendizaje automático con imágenes de satélite? En este blog, exploramos el mundo de las imágenes satelitales en la agricultura y cómo incorporar el aprendizaje automático en el proceso. Nos centraremos en las complejidades de la preparación de datos, los modelos utilizados y las posibles aplicaciones. ¡Conoceremos los detalles del uso de imágenes satelitales para analizar los cultivos, clasificarlos y estimar la densidad de la vegetación para ayudar a los agricultores a aumentar su productividad!

Ejemplos de casos de uso

La pregunta principal que podría venir a la mente es: «¿Cómo podemos utilizar las imágenes de satélite en la agricultura?» Bueno, hay muchos ejemplos. Quizás uno de los casos de uso más comunes sea identificar los tipos de cultivos en una región de interés. Sin embargo, la investigación actual ha abierto muchas posibilidades nuevas. Ahora repasaremos muchos ejemplos, centrándonos especialmente en cómo estas aplicaciones pueden aumentar la productividad:

Clasificación y segmentación de cultivos:

¡Imagínese poder identificar, encontrar y estimar el tamaño de diferentes tipos de cultivos en una región de interés, utilizando solo una imagen satelital de la región deseada! Uno de los enfoques más comunes para ello consiste en aplicar modelos de segmentación semántica (como los de Meta) Segmenta cualquier cosa6) en cada imagen. Este enfoque funciona muy bien como primera toma, aunque es posible que necesitemos modelos más grandes y complejos para lograr una precisión de última generación. También podemos usarlo para identificar características geográficas clave, como masas de agua o regiones áridas. Esta es, con mucho, la aplicación más común.

Seguimiento del ciclo de cultivo:

Una característica clave de las imágenes de satélite es que pueden proporcionar información sobre la vegetación de una región específica. Esto es posible gracias a los sensores ópticos especializados que pueden capturar información que no se puede ver a simple vista. Profundizaremos en los detalles en este blog. Por ahora, tenga en cuenta que, al utilizar esta información, es posible realizar un seguimiento de la salud de los cultivos para optimizar las prácticas agrícolas.

Predicción del rendimiento de los cultivos:

¿Qué tipo de información podemos obtener si estudiamos una región durante un período de tiempo específico? Al analizar varias imágenes tomadas durante un amplio período de tiempo, ¡es posible estimar el rendimiento de los cultivos para tomar mejores decisiones y planificar la cosecha!

Análisis del estado fenológico de los cultivos:

Por último, una de las prácticas más comunes en la agricultura es el fenotipado, que suele llevar mucho tiempo y mano de obra. Es posible monitorear los estados fenológicos de los cultivos con imágenes de satélite mediante el análisis de diversas características, como la floración y la maduración. Es posible obtener información sobre estos aspectos a partir de datos multiespectrales. Esto proporciona al agricultor mucha información para una mejor toma de decisiones.

Comprensión de los datos satelitales

Ahora hemos visto por qué las imágenes de satélite pueden ser útiles en la agricultura. Ahora, para ver cómo pueden ayudarnos, primero debemos entender los datos que nos pueden proporcionar.

Imágenes multiespectrales:

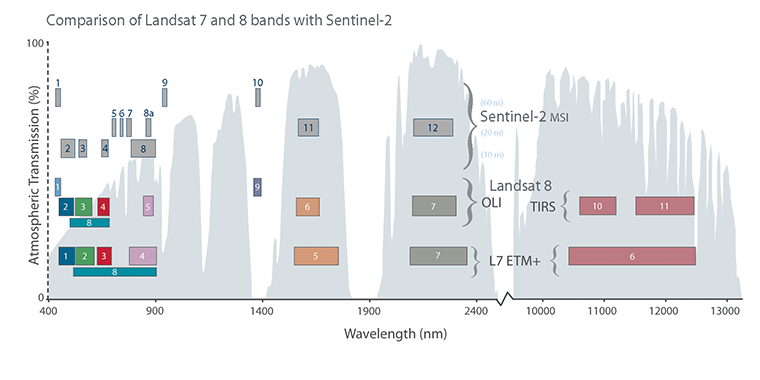

Actualmente, hay muchos tipos de satélites en órbita, cada uno con una amplia gama de sensores que proporcionan diferentes tipos de información. El tipo de datos más común que proporcionan los satélites consiste en imágenes en color de la superficie terrestre, obtenidas mediante sensores ópticos que capturan la luz visible. Si bien esto puede ser ciertamente útil, también podemos obtener información adicional si analizamos otras partes del espectro electromagnético, como el infrarrojo. Aquí es donde entra en juego el concepto de «imágenes multiespectrales». Las imágenes multiespectrales se crean mediante la captación de luz de diferentes bandas de frecuencias. A diferencia de las imágenes RGB normales, que tienen solo tres canales de color (rojo, verde y azul), las imágenes multiespectrales tienen muchos canales y cada uno muestra una banda de frecuencia diferente. En la figura 1 podemos ver cómo se distribuyen los diferentes canales en diferentes partes del espectro. [caption id="attachment_3279" align="aligncenter» width="760"]

Figura 1: distribución de los canales de imagen en todo el espectro electromagnético para varios satélites, como el Sentinel 2. (Fuente: centro EROS, Servicio Geológico de los Estados Unidos 8) [/subtítulo]

Índice de vegetación (VI) y temperatura de la superficie terrestre (LST):

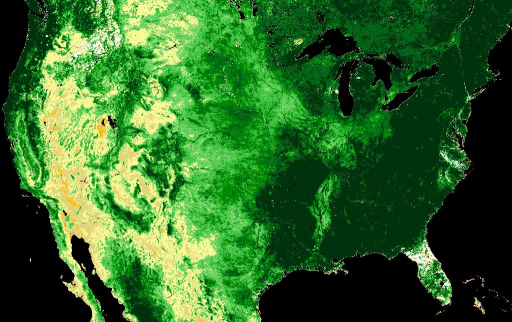

Muchos satélites también pueden medir la temperatura de la superficie terrestre (LST) de un área. Es decir, la temperatura de la superficie terrestre, ignorando las influencias atmosféricas, como el viento, la humedad, etc. Esto puede resultar muy útil para varios cultivos y también puede ayudarnos a encontrar las regiones óptimas para la agricultura. Pero quizás una de las herramientas más poderosas que nos pueden proporcionar los satélites es la capacidad de calcular un índice de vegetación (VI). Este índice se obtiene analizando los componentes de la luz roja e infrarroja y puede indicar la presencia de vegetación en un área. Hay muchas variaciones de este índice, siendo el NDVI el más conocido. Según nuestro caso de uso, podemos optar por diferentes implementaciones de esta métrica. Sin embargo, el concepto clave sigue siendo el mismo: medir la presencia de vegetación en una región de interés. [caption id="attachment_3281" align="aligncenter» width="512"]

Figura 2: ejemplo de imagen de NDVI. Obtenido de EarthExplorer, Servicio Geológico de los Estados Unidos 9[/subtítulo]

Radares de apertura sintética (SAR):

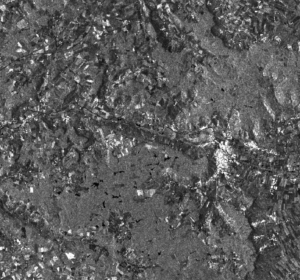

Como ya te habrás dado cuenta, las imágenes de los satélites son realmente poderosas. Vimos cómo podemos usarlo para medir la temperatura o la densidad de la vegetación, ¡lo que demuestra la cantidad de datos que podemos obtener! Desafortunadamente, todas estas fuentes de datos comparten la misma limitación: se obtienen de fuentes ópticas. Estos sensores funcionan capturando la luz del sol reflejada en la superficie terrestre. Por ello, hay muchos factores externos que pueden afectar a los datos recibidos, como el clima y otras condiciones atmosféricas impredecibles. Como alternativa, la mayoría de los satélites también cuentan con radares de apertura sintética o SAR. Los radares funcionan transmitiendo ondas de radio hacia un objetivo (en este caso, la superficie terrestre) y calculan la distancia a la que se encuentra en función del tiempo que tarda en volver el pulso reflejado. Los radares se pueden usar para cartografiar la superficie terrestre mediante la generación de una imagen de «nube de puntos». Los SAR son un tipo especial de radar que aprovecha el movimiento del satélite mientras orbita alrededor de la Tierra para mejorar la calidad de la imagen. A diferencia de la luz visible, las ondas de radio pueden atravesar libremente la atmósfera terrestre, lo que hace que las imágenes de SAR sean inmunes a las condiciones climáticas. Además, dado que no necesitan luz solar, los SAR se pueden utilizar en cualquier momento, ¡incluso de noche! Si bien todo esto parece una buena noticia, es importante tener en cuenta que, a diferencia de las imágenes tradicionales, los datos de SAR constan de un solo canal, razón por la cual la mayoría de los ejemplos consisten en imágenes en escala de grises. Esto significa que tenemos menos datos con los que trabajar. En la figura 3 se muestra un ejemplo de una imagen SAR:

[caption id="attachment_3295" align="aligncenter» width="300"]

Figura 3: Ejemplo de imagen SAR obtenida de Sentinel-1 (descargada de la plataforma Copernicus) 10) [/subtítulo]

Fuentes de datos

Uno de los aspectos más importantes de cualquier proyecto de IA es saber dónde podemos obtener datos para nuestros modelos. Hoy en día, gracias al esfuerzo de múltiples agencias de todo el mundo, las imágenes de satélite son más accesibles que nunca. Ahora repasaremos algunos proyectos que proporcionan un fácil acceso a diferentes tipos de datos satelitales:

- La Agencia Espacial Europea lanzó la misión «Sentinel-2», que consiste en 2 satélites que capturan imágenes multiespectrales de diferentes partes del mundo. Estas imágenes están disponibles públicamente a través del Plataforma Copernicus10 bajo una licencia Creative Commons CC BY-SA 3.0 IGO.

- El Explorador de la Tierra9 La plataforma fue desarrollada por el Servicio Geológico de los Estados Unidos y proporciona imágenes de una amplia variedad de misiones, como el Landsat de la NASA. Esta información es gratuita y consiste principalmente en imágenes RGB, aunque se pueden encontrar otros tipos de datos.

- El Instituto Nacional de Investigación Espacial de Brasil, en colaboración con China, ha publicado un catálogo de imágenes satelitales de América del Sur y África11. Al igual que en casos anteriores, esta información está disponible de forma gratuita, bajo la licencia internacional Creative Commons Attribution-ShareAlike 4.0.

Como podemos ver, hay muchas opciones entre las que elegir para extraer datos para nuestros proyectos. Todos estos esfuerzos también han permitido a muchas organizaciones desarrollar sus propios conjuntos de datos. Algunos de los cuales también están disponibles públicamente. Conjuntos de datos como EuroSat15, AgriFieldNet12 y el Gran red de tierra13 benchmark proporciona etiquetas para la clasificación y segmentación de cultivos, basadas en imágenes RGB y multiespectrales. Ya hemos visto muchas maneras en las que las imágenes de satélite se pueden utilizar para mejorar la productividad agrícola mediante el aprendizaje automático. También hemos visto qué datos nos pueden proporcionar los satélites y cómo acceder a ellos. ¡Ahora usaremos todo lo que hemos aprendido hasta ahora en unos pocos experimentos para demostrar el poder de estas tecnologías!

Ejemplos prácticos

Ya hemos discutido muchas aplicaciones de estas tecnologías en la agricultura. Sin embargo, ¡analizar todos estos casos requeriría más de una publicación en el blog! Ahora nos centraremos en dos ejemplos principales: la clasificación y la segmentación de cultivos, ya que son los más comunes.

Segmentación de cultivos mediante un modelo de segmentación de tiro cero

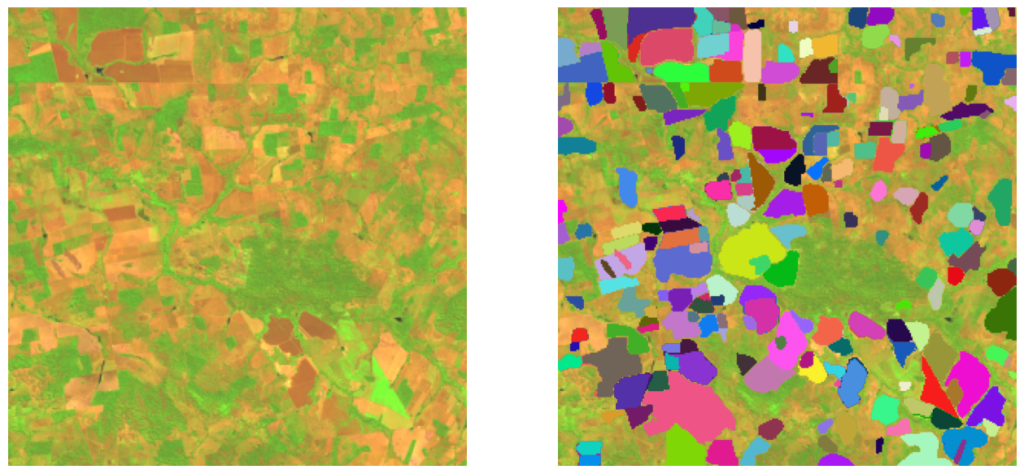

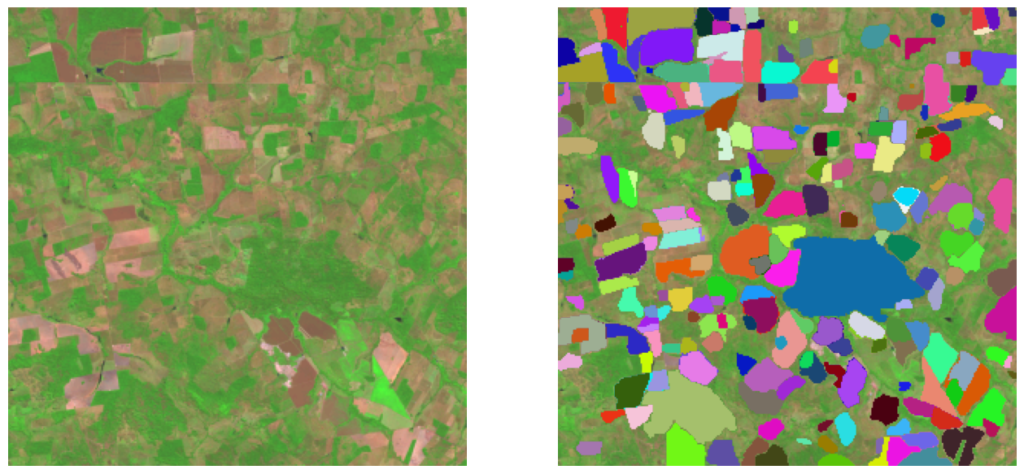

Ahora veremos un ejemplo sencillo en el que utilizaremos una red de segmentación en una serie de imágenes de satélite obtenidas de la misión Sentinel-2 para localizar varias parcelas y otras características clave en una región específica. Usaremos el Segmenta cualquier cosa6 modelo (SAM) como red de segmentación para estos experimentos. Es importante tener en cuenta que estamos realizando esta prueba con un modelo de tiro cero, lo que significa que nuestro modelo aún no ha sido entrenado con imágenes de satélite para este propósito específico. Las imágenes utilizadas en esta demostración se obtuvieron de la misión Sentinel-2, a través de la plataforma Copernicus. Como se trata de imágenes multiespectrales compuestas por 12 canales y SAM solo puede funcionar con imágenes RGB normales, tendremos que elegir 3 bandas de la imagen descargada para crear un «compuesto RGB» que pueda enviarse a la red. Para nuestro primer experimento, elegiremos las bandas B-04, B-03 y B-02, ya que corresponden a la luz roja, verde y azul del espectro, respectivamente. Podemos ver un ejemplo de esta imagen en la figura 4: [caption id="attachment_3284" align="aligncenter» width="300"]

Figura 4: ejemplo de una imagen de satélite RGB. Obtenido de EartExplorer, Servicio Geológico de los Estados Unidos 9[/caption] Ahora usaremos el modelo Vit-H de SAM para obtener una máscara de segmentación en la imagen dada. Tenga en cuenta que, si bien esto nos permite determinar la ubicación y el tamaño de los cultivos y otras características clave, no identifica cada tipo de cultivo. Para lograrlo, tendremos que capacitar a nuestra red para que también lleve a cabo la clasificación. Una vez que procesamos la imagen a través de la red de segmentación, obtenemos una máscara como esta: [caption id="attachment_3286" align="aligncenter» width="512"]

Figura 5: imagen de satélite original (izquierda) frente a la salida de segmentación (derecha) [/caption]

Como podemos ver, la red es capaz de identificar y segmentar diferentes cultivos en la imagen, aunque por ahora no puede distinguir cada tipo de cultivo. Podríamos usar esta información para realizar un seguimiento de la distribución de los cultivos en una región específica, lo que podría ser útil para analizar las tierras agrícolas disponibles. Recuerde que esto se hizo con un modelo de cero posibilidades, ¡imagine lo que podríamos lograr con más capacitación!

Combinación de diferentes bandas espectrales

Ahora, solo hemos usado 3 de las 12 bandas espectrales disponibles. ¿Qué tipo de información podríamos obtener del resto de los canales? Como hemos visto antes, SAM solo puede procesar imágenes con 3 canales, por lo que una solución normal es crear otras combinaciones utilizando diferentes bandas espectrales. Podemos encontrar muchas combinaciones en el Repositorio Sentinel-hub16, adecuado para diversas aplicaciones. Estas combinaciones se denominan «compuestos RGB». Por ejemplo, el compuesto de «color falso», que consiste en las bandas B08, B04 y B03, se usa comúnmente para conocer la densidad y la salud de las plantas. Además, un compuesto de «infrarrojo de onda corta», que utiliza las bandas B12, B08 y B04, puede dar una idea muy clara de la cantidad de agua presente en las plantas y el suelo, lo que puede resultar útil para detectar los daños causados por los incendios. Podemos experimentar con estos compuestos combinando otras bandas e introduciendo la imagen resultante a través de la red de segmentación para ver qué resultados obtenemos. Para esta prueba de concepto, utilizamos principalmente 3 compuestos RGB. Cada uno de ellos, así como los resultados obtenidos, se muestran a continuación: [caption id="attachment_3287" align="aligncenter» width="512"]

Figura 6a: Resultados de segmentación para las bandas B11, B8 y B2 [/caption] [caption id="attachment_3289" align="aligncenter» width="512"]

Figura 6b: Resultados de segmentación para las bandas B12, B8 y B4 [/caption] [caption id="attachment_3290" align="aligncenter» width="512"]

Figura 6c: Resultados de segmentación para las bandas B11, B8A y B4 [/caption] Podemos ver que las máscaras obtenidas difieren según el compuesto RGB utilizado. Esto muestra cómo cada una de estas bandas contiene información diferente que nuestro modelo puede interpretar de manera diferente. Para algunas aplicaciones, el uso de uno de estos compuestos puede ser suficiente. Sin embargo, todavía hay mucha información que podemos utilizar. Nuestros próximos pasos serían experimentar con estas bandas espectrales, probar diferentes combinaciones y agregar diferentes técnicas de procesamiento para ver si podemos mejorar los resultados. También podemos probar con diferentes modelos de segmentación o incluso entrenar nuestro propio modelo personalizado. Como podemos ver, hay muchas posibilidades, ¡el mundo de las imágenes de satélite es realmente poderoso!

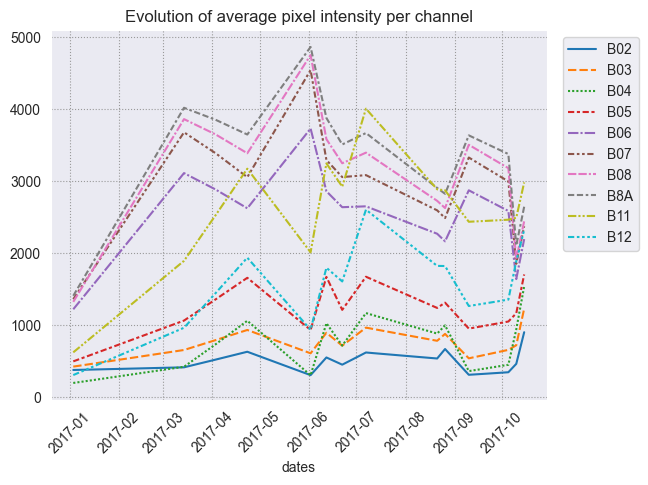

Clasificación de cultivos con series temporales de imágenes de satélite

Como hemos visto antes, la clasificación de cultivos es uno de los casos de uso más comunes. Sin embargo, a diferencia de nuestro ejemplo anterior, suele ser una tarea mucho más complicada. Esto se debe a que la luz reflejada por los recortes suele variar con el tiempo, lo que dificulta mucho la clasificación con una sola imagen. Como alternativa, muchas propuestas vanguardistas suelen implicar el uso de series temporales de imágenes de satélite. Al tener varias imágenes del mismo recorte durante un período de tiempo específico, podemos ver cómo evoluciona la reflectancia de la luz. Podemos usar esta información para determinar el tipo de cultivo, ya que los diferentes cultivos suelen tener diferentes reflectancias de luz. Para demostrarlo, podemos ver un ejemplo de la variación de la reflectancia de la luz de los cultivos de colza de invierno a lo largo del tiempo en diferentes bandas espectrales: [caption id="attachment_3291" align="aligncenter» width="648"]

Figura 7: evolución de la intensidad media de píxeles por banda espectral (canal de imagen) para la colza de invierno. Datos obtenidos en 24 fechas diferentes, desde enero de 2017 hasta octubre del mismo año.

Fuente: Garnot, Vivien Sainte Fare y col. 1[/caption] Esto demuestra claramente que, para clasificar correctamente los cultivos, debemos hacer uso de series temporales de datos. Por ello, muchos modelos de aprendizaje automático para esta tarea suelen implementar arquitecturas para datos secuenciales, como los transformadores. Esto hace que estos modelos sean más costosos desde el punto de vista computacional que las redes neuronales convolucionales o totalmente conectadas tradicionales, pero proporcionan resultados considerablemente mejores.

Puntos de referencia actuales

Gracias al esfuerzo de muchas organizaciones que han trabajado en múltiples puntos de referencia de clasificación de cultivos, existe una amplia variedad de modelos entre los que elegir. Un ejemplo es esta implementación de Garnot et al1 que afirma lograr hasta Precisión general del 94,2% en tareas de clasificación. Si bien esto es ciertamente impresionante, una desventaja es la cantidad de tiempo que lleva generar los datos de entrenamiento necesarios. Afortunadamente, los autores publicaron un conjunto de pesas preentrenadas listas para la inferencia, así como el conjunto de datos de entrenamiento original. ¡Con estos recursos, podemos establecer nuestro propio proceso de clasificación de cultivos en poco tiempo! Hemos realizado nuestras pruebas personalizadas con este modelo, utilizando un pequeño conjunto de datos de 500 cultivos. Los resultados fueron bastante prometedores. No solo obtuvimos una precisión del 94%, sino también unos buenos valores generales de precisión y recuperación en la mayoría de las clases: por ejemplo, la puntuación de precisión de los cultivos de girasol y trigo duro de primavera fue del 85,7% y el 98,3%, respectivamente. Por otro lado, otros tipos de cultivos, como los cereales, obtuvieron puntuaciones de precisión más bajas, de hasta un 55%. Lo más probable es que esto se deba a un desequilibrio de datos en nuestro conjunto de datos. Otros trabajos prometedores incluyen esta implementación de Vision Transformers para la clasificación de cultivos mediante series temporales de imágenes de satélite, realizada por Michail Tarasiou y col.2. Este modelo también se puede utilizar para la segmentación de cultivos, lo cual es una gran ventaja. Sin embargo, su precisión es un poco más lenta que la de nuestro modelo anterior, con una puntuación del 87,1%. Como podemos ver, la clasificación de los cultivos es, de hecho, una tarea compleja. Pero es una herramienta increíblemente poderosa. Especialmente cuando se combina con nuestros experimentos de segmentación anteriores.

Reflexiones finales

En este blog, echamos un primer vistazo al mundo de las imágenes satelitales y sus aplicaciones en la agricultura. Hemos analizado los datos que ofrece y hemos descubierto cómo conseguirlos. Vimos su verdadero potencial cuando se combina con el aprendizaje automático. Y lo que es más importante, vimos la amplia gama de posibilidades que estas dos herramientas pueden ofrecer cuando se combinan y se usan juntas. Está claro que las imágenes de satélite tienen muchos desafíos que superar. Pero gracias a la mejora constante de los modelos de aprendizaje automático, ¡podemos esperar obtener mejores resultados en el futuro!

Referencias:

- V. S. F. Garnot, L. Landrieu, S. Giordano, N. Chehata, Clasificación de series temporales de imágenes de satélite con codificadores de conjunto de píxeles y autoatención temporal, Arxiv: 1911.07757, 2020.

- Sr. Tarasiou, E. Chávez, S. Zafeiriou, ViTS for SITS: transformadores de visión para series temporales de imágenes satelitales, Arxiv: 2301.04944, 2023.

- Cuántica, Clasificación de tipos de cultivos con imágenes de satélite, Medium.com, 14 de agosto de 2022.

- A. H. Khan, M. M. Fraz, M. Shahzad, Clasificación de la cobertura terrestre y los tipos de cultivos basada en el aprendizaje profundo: un estudio comparativo, 2021.

- R. C. Daudt, B. L. Saux, A. Boulch, Y. Gousseau, Detección de cambios urbanos para la observación multiespectral de la tierra mediante redes neuronales convolucionales, Arxiv: 1810.08468, 2018.

- Alexander Kirillov y col. , Segmenta cualquier cosa, Meta AI Research, arXiv: 2304.02643, 2023.

- Guías de usuario - Sentinel-2 MSI - Descripción general - Sentinel Online, Sentinel Online, consultado el 10 de octubre de 2023.

- Comparación de Sentinel-2 y Landsat Active, Archivo EROS del USGS, EE. UU. Servicio Geológico, 1 de marzo de 2019.

- Explorador de la Tierra, Servicio Geológico de los Estados Unidos, consultado el 10 de octubre de 2023.

- Navegador Copernicus, Agencia Espacial Europea, consultado el 5 de febrero de 2024

- Catalogo de imágenes, INPE, consultado el 10 de octubre de 2023.

- Desafío AgriFieldNet India, Zindi, consultado el 10 de octubre de 2023.

- G. Sumbul, Sr. Charfuelan, B. Demir, V. Markl, BigEarthNet: un archivo de referencia a gran escala para la comprensión de imágenes de teledetección, arXiv: 1902.06148, 2019.

- Compuestos RGB simples (Sentinel-2), Sentinel-Hub. Consultado el 10 de octubre de 2023.

- ¿Qué es el radar de apertura sintética?, Sistemas de datos de ciencias de la Tierra, NASA, 10 de abril de 2020.

- ¿Qué es el NDVI (índice diferencial normalizado de vegetación)?, GISGeography, 14 de julio de 2023.

- Temperatura de la superficie terrestre, Servicio Terrestre Global de Copernicus, 30 de marzo de 2023.

.png)