.png)

Diferença entre Gemma e Gemini

Introdução

O Google, particularmente seu esquadrão DeepMind, lançou um conjunto de modelos leves, chamados Gemma, os mesmos envolvidos na criação do Gemini. Ele está disponível em dois tamanhos, 2B e 7B. Ele vem com um excelente kit de ferramentas de IA generativa responsável, um SFT para várias estruturas e bibliotecas e colabs prontos para uso. Modelos pré-treinados ou personalizados podem ser executados localmente - sim, localmente - ou por meio de GPU, onde a equipe do Google aprimorou o desempenho da NVIDIA e do Google Cloud TPU. Além disso, seus termos de uso permitem o uso comercial. Portanto, se você estava se perguntando sobre sua conveniência ou a combinação entre seu caso de uso e Gemma - em qualquer um de seus sabores -, a resposta é sim! Continue lendo para saber o que está por trás do capô.

Crie estratégias e restrições

O Gemma foi construído seguindo o Responsible Generative AI Toolkit, que adiciona uma camada de segurança em relação ao comportamento dos aplicativos LLM. Para fazer isso, não apenas as informações pessoais, mas também as informações confidenciais também foram removidas dos conjuntos de treinamento e o ajuste fino e o aprendizado por reforço a partir do feedback humano (RLHF) foram usados para obter respostas responsáveis dos modelos ajustados à instrução. Para a avaliação, várias abordagens foram implementadas. Desde a formação manual de equipes vermelhas até testes adversários automatizados e avaliações das capacidades do modelo para atividades perigosas.

Gemma e Gêmeos

Qual é a diferença entre Gemma e Gemini? Em que cada um deles está focado? Principalmente em seu público-alvo, propósito e tamanho. Enquanto o Gemma é de código aberto e leve, o Gemini é proprietário e pesado. Além disso, o Gemma deve ser usado por desenvolvedores e pesquisadores, exceto o Gemini, para pesquisas avançadas de IA e aplicativos de grande escala. A tabela a seguir mostra um comparativo mais detalhado: Gemma Gemini Compatibilidade proprietária de código aberto com JAX, PyTorch e TF -over keras 3.0- restrita ao ecossistema do Google

Aplicativos e arquiteturas

Tanto Gemma quanto Gemini podem ser usados para:

- Geração de texto: responda perguntas, gere texto ou resuma-o

- Processamento de imagens: tarefa de legendagem de imagens, perguntas visuais e tarefas de resposta

Os dois podem ser uma entidade em sua solução, mesmo se você estiver criando com uma arquitetura de microsserviço ou monolítica. As principais diferenças dependem de suas responsabilidades e capacidade de personalização. Vamos considerar que você está trabalhando com base em microsserviços, onde cada um tem uma meta adequada para servir.

Caso de uso do Gemma

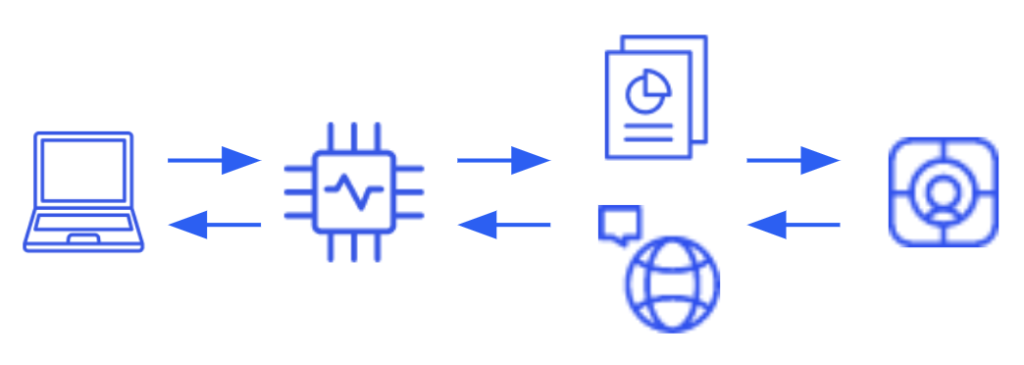

Uma arquitetura típica com o Gemma requer pelo menos um microsserviço dedicado a hospedar o modelo para interagir com as solicitações recebidas. Além disso, se você pretende melhorar suas respostas com base em conhecimentos específicos - abordagem RAG - um vetor DB também será necessário. Por um lado, isso tem a vantagem de um nível praticamente infinito de personalização, desde melhorar o próprio modelo com dados específicos até aprimorar seu desempenho em relação à adição de contexto ao prompt - incluindo os documentos referidos -. Por outro lado, sempre há um problema, ou pelo menos algo a considerar, e aqui não há exceção. Nesse caso, você não é responsável apenas pelo desenvolvimento da solução, mas também pela infraestrutura necessária para executá-la onde provavelmente são necessários recursos com GPU, o que também afeta o faturamento.

Caso de uso do Gemini

Uma arquitetura típica do Gemini não é tão exigente quanto a anterior quanto à infraestrutura e às funções necessárias, porque você pode acessar o modelo como um serviço externo -SaaS-. Centralizar a integração em um serviço ou módulo será suficiente. Isso tem a vantagem de cumprir o mínimo de tarefas em termos de quantidade de horas de trabalho, configuração de infraestrutura e controle de acesso, o que é benéfico se um rápido tempo de comercialização for crucial, basta acessar o Gemini com as credenciais adequadas. No entanto, você está renunciando à sua capacidade de personalização. Embora você possa trabalhar de acordo com suas solicitações, no final elas são um texto limitado, portanto, trabalhar com o RAG para adicionar documentos específicos do domínio ao modelo ou treiná-lo novamente para atender às suas necessidades, não é uma alternativa disponível.

Conjuntos de modelos Gemma

Gemma

Gemma é uma LLM, com ótimos resultados em tarefas de geração de texto, incluindo resposta a perguntas, resumos e raciocínio.

Pali Gemma

O PaliGemma é um modelo leve de linguagem de visão aberta (VLM), portanto, ele usa imagens e texto como entradas e pode responder perguntas sobre imagens com detalhes e contexto. Portanto, o modelo é capaz de realizar análises de imagens fornecendo legendas para imagens e vídeos curtos, detecção de objetos e leitura de texto incorporado nas imagens. Existem dois sabores de Paligemma, um de uso geral -Paligemma- e um voltado para a pesquisa -Paligemma-FT-. A primeira é uma ótima opção como ponto de partida para modelos ajustados para uma variedade de tarefas, a segunda já está ajustada em conjuntos de dados de pesquisa específicos. Alguns recursos do PaliGemma incluem compreensão multimodal, compreensão simultânea de imagens e texto, e a possibilidade de aperfeiçoar uma ampla gama de tarefas de linguagem visual.

Código Gemma

O CodeGemma é uma coleção de modelos que podem realizar uma variedade de tarefas de codificação, como preenchimento intermediário de código, geração de código, compreensão de linguagem natural, raciocínio matemático e acompanhamento de instruções. Nesse caso, existem 3 configurações à disposição. Uma variante pré-treinada 7B especializada em preenchimento e geração de código a partir de prefixos e/ou sufixos de código, depois uma versão 7B ajustada para instruções para bate-papo de linguagem natural para código e acompanhamento de instruções e, finalmente, uma versão pré-treinada 2B que fornece preenchimento de código mais rápido. Entre as vantagens do CodeGemma, existem recursos como preenchimento e geração de código com proficiência em vários idiomas - a pilha inclui Python, JS, Kava, Kotlin, C++, C#, Rust, Go, entre outros.

Gemma recorrente

O RecurrentGemma é um modelo aberto baseado em Griffin, pois o Gemma simples é adequado para tarefas de geração de texto, incluindo resposta a perguntas, resumos e raciocínio, mas com alguns benefícios extras, em particular, uso reduzido de memória, maior taxa de transferência e alto desempenho.

Visão geral das especificações e do arco

Gemma decolou do programa Gemini, incluindo código, dados, arquitetura, ajuste de instruções, aprendizado por reforço a partir do feedback humano e avaliações. Há alguns aspectos que merecem ser mencionados, como: Atenção de várias consultas em vez da atenção original de várias cabeças é usada, incorporações de RoPE em cada camada, ativação de GeGlu em vez de ReLu e Localização do Normalizador - normalize a entrada e a saída de cada subcamada do transformador usando RMSNorm.

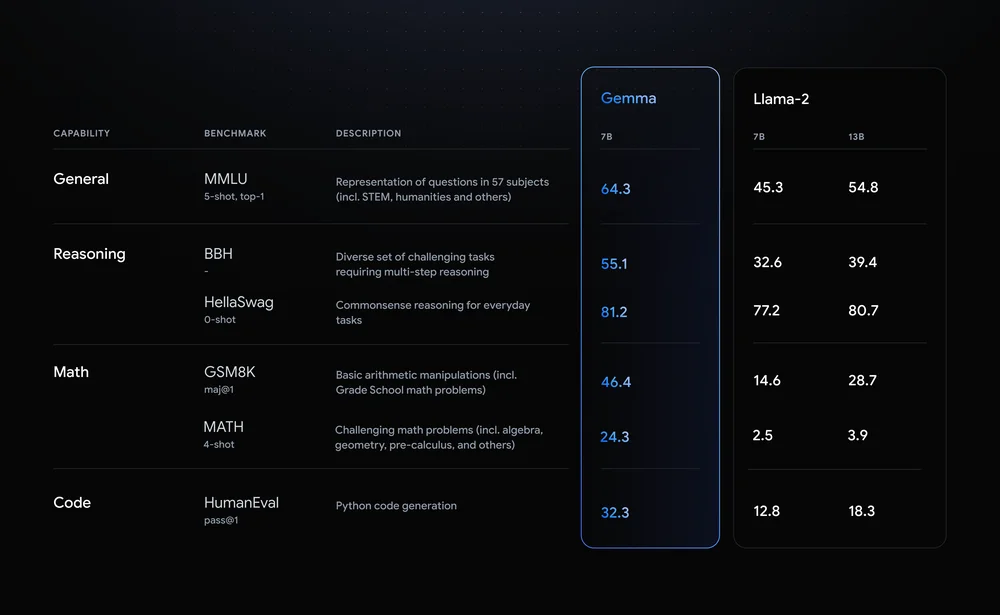

Comparativo

Até agora, tudo bem. Mas se em seus projetos, iniciativas ou qualquer outra coisa em que você esteja trabalhando, você já estiver usando outros modelos de código aberto, como o Llama, você pode se perguntar por que fazer o esforço de pivotar. Aqui está o motivo: o Google comparou o Gemma 7B com o Llama 2 7B da Meta em vários domínios, como raciocínio, matemática e geração de código. Dê uma olhada na tabela abaixo, onde Gemma superou o Llama-2 em todos os aspectos.

Integração e adoção

Como já mencionado, a integração entre os modelos Gemma e as estruturas principais está pronta para uso, desde a exploração ingênua do Kaggle até implantações totalmente produtivas. No entanto, isso não é tudo, você pode combinar o Gemma com o HuggingFace para tarefas de ajuste e inferência por meio de seus Transformers, com a NVIDIA para ajustar também, com o LangChain para criar aplicativos com LLM - apoiado pela Gemma -, com o MongoDB para construir o sistema RAG e outros.

Conclusão

Uma nova família de modelos está disponível e você deve dar uma olhada e provavelmente começar a usá-la para agregar valor à sua ideia/negócio ou pesquisa! Esse conjunto é de código aberto, com uma comunidade excelente e dinâmica e o máximo de economia de recursos possível, então a decolagem parece promissora. De qualquer forma, o roteiro deve sempre ser considerado para não falhar. É aqui que as ferramentas para aproximações iniciais, também conhecidas como cadernos disponíveis, entram em cena. Elas são um bom ambiente de sandbox para interagir com Gemma!

.png)