Protocolo de contexto modelo: integración de agentes en la nube de IA

Hoy en día, la inteligencia artificial está remodelando la forma en que construimos y operamos los sistemas, especialmente en el campo de la ingeniería. Desde la aceleración de los ciclos de desarrollo hasta la automatización de las tareas, la IA se está convirtiendo en una herramienta práctica en los flujos de trabajo diarios. A medida que la integración de la IA en la nube evoluciona y los agentes inteligentes se conectan más profundamente con plataformas como AWS y Azure, los entornos de nube comienzan a comportarse menos como una infraestructura estática y más como sistemas adaptativos que pueden funcionar junto con la IA en tiempo real.

¿Qué es el Protocolo de contexto modelo (MCP)?

Imagínese a un traductor en una conferencia concurrida: en lugar de que cada persona hable diferentes idiomas y trate de entenderse, el traductor crea un lenguaje común que todos puedan entender. De manera similar, MCP actúa como traductor, lo que permite que varios sistemas en la nube y agentes de inteligencia artificial se comuniquen sin problemas, independientemente de sus interfaces nativas. Los principales proveedores de servicios en la nube, como Amazon y Microsoft, ya están adoptando este modelo. Están empezando a ofrecer sus servicios a través de servidores compatibles con MCP, lo que allana el camino para la infraestructura nativa de la IA. Si bien tanto AWS como Azure comparten la misma visión: hacer que la nube sea más inteligente y fácil de usar para los agentes, la abordan de maneras muy diferentes. En este blog, analizaremos cómo AWS y Azure están implementando el MCP, compararemos los puntos fuertes de sus ofertas actuales y analizaremos lo que esto significa para los equipos de ingeniería que buscan potenciar sus flujos de trabajo en la nube con inteligencia artificial. Por lo tanto, ya sea que esté creando con agentes en la actualidad o planificando un futuro más inteligente, comprender el panorama del MCP es cada vez más esencial.

Descripción general de alto nivel

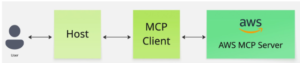

Figura 1: Arquitectura MCP

La arquitectura de MCP se divide en tres componentes principales: el host, el cliente y el servidor. Este diseño modular garantiza la escalabilidad, la flexibilidad y la facilidad de integración en diferentes plataformas y servicios.

Anfitrión MCP

El host representa la aplicación que utiliza el agente de IA. Algunos ejemplos son las aplicaciones de chat, los entornos de desarrollo integrados (IDE) o cualquier software que requiera funcionalidades de inteligencia artificial. El anfitrión es responsable de iniciar las interacciones y, a menudo, abarca el componente del cliente.

Cliente MCP

Integrado en el host, el cliente actúa como intermediario entre el host y el servidor. Formula las solicitudes en función de las necesidades de la aplicación o las entradas del usuario y las comunica al servidor. Además, el cliente procesa las respuestas recibidas del servidor, lo que facilita las acciones apropiadas dentro de la aplicación host.

Servidor MCP

El componente del servidor tiene la tarea de ejecutar las operaciones solicitadas por el cliente. Además, interactúa con varios recursos externos, como bases de datos, API o archivos locales, para realizar las tareas necesarias. Al final del ciclo, devuelve los resultados al Cliente, completando el ciclo de comunicación. Si está interesado en profundizar en el funcionamiento de esta arquitectura en la práctica (incluida una guía paso a paso para crear su propio servidor MCP), consulte nuestra entrada de blog detallada sobre la arquitectura MCP y la implementación del servidor.

Integración de servidores MCP para proveedores de nube

Con la arquitectura MCP, la integración de servicios en la nube como Amazon o Azure es bastante sencilla: basta con conectarse a su servidor MCP y acceder a todas las funciones disponibles sin crear herramientas independientes para cada servicio en cada agente. Una interfaz, infinitas posibilidades.

Flujo de trabajo operativo

Figura 2: Un usuario interactúa con el servidor AWS MCP

La interacción dentro de la arquitectura MCP sigue un flujo de trabajo sistemático:

- Interacción del usuario: Un usuario inicia una solicitud a través de la aplicación host (por ejemplo, consultando los datos del cliente).

- Formulación de la solicitud: El cliente procesa esta entrada y formula una solicitud estructurada.

- Comunicación con el servidor: El cliente envía la solicitud al servidor, que identifica las herramientas o fuentes de datos adecuadas necesarias para cumplir con la solicitud.

- Ejecución y respuesta: El servidor ejecuta las operaciones necesarias, recupera los datos requeridos y envía los resultados al cliente.

- Entrega de resultados: El cliente procesa la respuesta y presenta la información al usuario a través de la aplicación host.

Los agentes de IA y los servicios en la nube se unen a través de MCP

Servidores AWS MCP: mejora de las capacidades de IA con los servicios de AWS

Como parte de su esfuerzo por hacer que la nube sea más accesible para los flujos de trabajo nativos de la IA, AWS ha presentado una familia de servidores Model Context Protocol (MCP). Estos Servidores AWS MCP están diseñados para brindar a los agentes de IA un acceso seguro y completo a una variedad de capacidades de AWS mediante protocolos estandarizados. Cada servidor se centra en un dominio específico, como:

- Documentación de AWS: permite a los agentes buscar, recuperar y convertir los documentos de AWS en respuestas estructuradas

- Análisis de costos: permite a los agentes consultar los datos de facturación y uso

- Terraform y CDK: ayudan a generar o validar la infraestructura como código

- Amazon Aurora MySQL: permite la generación de SQL y la introspección de esquemas para Aurora MySQL

- AWS Lambda: permite la implementación y la administración de funciones mediante instrucciones guiadas para los agentes

- Bases de conocimiento de Amazon Bedrock: permiten el descubrimiento y la consulta en lenguaje natural de los KB de Bedrock

- Amazon Nova canvas: genera imágenes basadas en texto o guiadas por colores con integración de espacios de trabajo

- Diagrama de AWS: genera diagramas de infraestructura, secuencia o flujo a partir del código Python

- AWS CloudFormation: permite las operaciones CRUDL en los recursos de AWS mediante Cloud Control

- Amazon SNS/SQS: permite a los agentes crear temas/colas, enviar y recibir mensajes y gestionar atributos

- Interfaz: proporciona documentación y orientación para el desarrollo de interfaces modernas en AWS

- AWS Location Service: permite la geolocalización, la búsqueda de lugares, la geocodificación inversa y la optimización de rutas

- Investigación de repositorios de Git: realiza búsquedas semánticas y análisis de estructura en los repositorios de Git

- Amazon Aurora PostgreSQL: convierte las preguntas en SQL y ejecuta consultas en Aurora Postgres

- Generación de documentación de código: genera automáticamente documentación y diagramas a partir de repositorios de código

- Amazon Neptune: ejecuta consultas de OpenCypher y Gremlin en las bases de datos de Neptune

El funcionario awslabs/mcp Las series de blogs de repositorios y AWS describen el MCP como una capa fundamental de una visión más amplia: utilizar herramientas basadas en agentes para acelerar la adopción de la nube, reducir la fricción de DevOps y simplificar los flujos de trabajo complejos para los desarrolladores, los equipos de plataformas e incluso los usuarios no técnicos.

Primeros días: documentación limitada y soluciones creadas por la comunidad

Si bien AWS ha publicado estos servidores MCP, la documentación oficial sigue siendo limitada, especialmente cuando se trata de usarlos fuera de los IDE. Herramientas como Microsoft VS Code ya son compatibles con MCP y proporcionan guías de configuración generales (code.visualstudio.com), y los clientes como Cline y Claude Desktop se pueden configurar para que se conecten a los servidores MCP. Sin embargo, actualmente no hay tutoriales detallados sobre cómo usar estos servidores MCP específicos (como el servidor de documentación de AWS o el servidor Lambda) en agentes independientes o en flujos de trabajo locales personalizados. AWS ha anunciado la compatibilidad inicial con MCP a través de publicaciones de blog (aws.amazon.com) y proporciona las implementaciones principales en GitHub (awslabs/mcp). También ofrecen un SDK como parte de Amazon Bedrock Agents, que simplifica el trabajo con MCP, pero establece explícitamente que los desarrolladores que no utilicen este SDK deben escribir y mantener una lógica personalizada para gestionar las respuestas, controlar el flujo y gestionar el estado de los agentes. Como resultado, muchos desarrolladores están creando conectores y scripts personalizados para automatizar las interacciones con los servidores MCP y conectarlos a sistemas multiagente o configuraciones locales. En resumen, si bien las integraciones de IDE ya están surgiendo, el ecosistema para el uso de MCP independientes o integrados aún está madurando y la comunidad actualmente confía en los ejemplos de GitHub y en las herramientas de creación propia para cerrar la brecha.

Servidor Azure MCP: integración de agentes de IA con servicios de Azure

Paralelamente a las tendencias del sector, Microsoft ha presentado el servidor Azure MCP, una puerta de enlace unificada y ampliable que conecta los agentes de IA con los servicios de Azure a través del lenguaje natural. A diferencia de AWS, que ofrece varios servidores MCP especializados, Azure consolida múltiples integraciones de servicios en una arquitectura de servidor unificada. Actúa como puente entre los LLM y los servicios de Azure mediante una comunicación inteligente basada en JSON diseñada para los agentes de inteligencia artificial, la traducción del lenguaje natural a la API para las operaciones de Azure, la finalización automática y las sugerencias inteligentes de parámetros, una gestión de errores coherente y explicable y un modelo de complementos basado en herramientas que facilita la ampliación o la personalización.

Herramientas integradas

En lugar de varios puntos finales de MCP, Azure MCP ofrece un conjunto de herramientas dentro de un servidor, cada uno correspondiente a un servicio de Azure compatible. Estas herramientas incluyen actualmente:

- Azure AI search: lista/busca servicios e índices, inspecciona esquemas y vectores de consulta

- Cosmos DB: consulte contenedores, administre elementos y ejecute SQL en bases de datos NoSQL

- Azure Data Explorer: ejecute consultas de KQL, inspeccione clústeres, bases de datos y tablas

- PostgreSQL: inspeccione el esquema, enumere bases de datos/tablas y ejecute consultas

- Azure Storage: administre contenedores de blobs, blobs y almacenamiento de tablas

- Prácticas recomendadas y herramientas: patrones de uso seguros y recomendados de Surface para los SDK de Azure

- Azure Monitor (Log Analytics): ejecute KQL en los espacios de trabajo e inspeccione los esquemas de registro

- Azure Key Vault: administre y recupere claves

- Configuración de aplicaciones de Azure: gestione los valores clave y los ajustes de configuración

- Azure Service Bus: vea los metadatos de la cola, el tema o la suscripción

- Grupos de recursos de Azure: enumerar e inspeccionar grupos

- Azure CLI + CLI para desarrolladores: ejecute los comandos de la CLI directamente mediante las instrucciones del agente

Integración unificada de IA con GitHub Copilot y clientes personalizados

El servidor MCP de Azure representa un avance significativo en la integración de los agentes de IA con los servicios de Azure. Al consolidar múltiples integraciones de servicios en una única arquitectura de servidor, simplifica el proceso de desarrollo de aplicaciones impulsadas por la IA. Este enfoque unificado permite a los agentes de IA interactuar con varios servicios de Azure, incluidos Cosmos DB, Azure Storage y Azure Monitor, mediante comandos en lenguaje natural. Sin embargo, es importante tener en cuenta que el servidor MCP de Azure aún se encuentra en sus versiones iniciales. Actualmente, las opciones de integración son limitadas, y la compatibilidad principal es con el modo de agente Copilot de GitHub en Visual Studio Code y con los clientes MCP personalizados. Este limitado alcance de integración puede dificultar una adopción más amplia, especialmente para los desarrolladores que buscan flexibilidad en sus cadenas de herramientas. A pesar de estas limitaciones, el proceso de integración con GitHub Copilot en Visual Studio Code es notablemente sencillo. Los desarrolladores pueden configurar el servidor MCP de Azure configurando un archivo mcp.json simple dentro del espacio de trabajo de su proyecto. Una vez configurado, el modo de agente de GitHub Copilot puede utilizar sin problemas el servidor MCP de Azure, lo que permite interactuar en lenguaje natural con los servicios de Azure directamente desde el entorno de desarrollo

MCP en acción: practique con los servidores de AWS y Azure

Uso del servidor MCP de documentación de AWS con Docker y Cursor: guía paso a paso

A pesar de la naturaleza inicial de las herramientas MCP, ya es posible experimentar con servidores específicos en una configuración local. Uno de los más sencillos para empezar es el servidor MCP de documentación de AWS, ya que funciona bien en entornos aislados. El servidor MCP de documentación de AWS proporciona a los agentes de IA herramientas para interactuar de forma inteligente con la documentación de AWS. Expone tres capacidades principales:

- leer documentación (url) que recupera una página de documentación completa de AWS y la convierte en texto limpio y con formato Markdown

- search_documentation (frase_búsqueda, límite) que utiliza la API de búsqueda de documentación oficial de AWS para encontrar páginas relevantes en función de una palabra clave o frase

- recomendar (url) que devuelve una lista de páginas de documentación relacionadas para ayudar a los agentes a sugerir contenido complementario.

Estas herramientas permiten a los agentes extraer información precisa, responder a preguntas técnicas y proporcionar referencias útiles, todo ello basado en la documentación oficial de AWS. Antes de empezar, asegúrate de tener lo siguiente:

- Estibador instalado y en ejecución.

- Cursor instalado.

- Un entorno Python funcional (opcional si solo usas Docker).

- Credenciales de AWS configuradas en su máquina (para otras herramientas de MCP, no son estrictamente necesarias para la documentación de MCP).

Paso 1: Clonar y construir el servidor MCP

Clona el repositorio y crea la imagen de Docker localmente: git clone https://github.com/awslabs/aws-documentation-mcp-server.git cd aws-documentation-mcp-server docker build -t awslabs/aws-documentation-mcp-server. Una vez que la compilación esté completa, tendrás una imagen de Docker lista para usar.

Paso 2: configurar MCP en Cursor

Cursor admite configuraciones MCP globales y a nivel de proyecto a través de un archivo JSON. En la carpeta de tu proyecto (o globalmente a través de ~/.cursor/mcp.json), agrega lo siguiente en .cursor/mcp.json: {«MCPServers»: {«awslabs.aws-documentation-mcp-server»: {«command»: «docker», «args»: [«run», «--rm», «--interactive», «--env», «FASTMCP_LOGG» _LEVEL=ERROR», «awslabs/aws-documentation-mcp-server:latest»], «env»: {}, «disabled»: false, «AutoApprove»: []}} Esto le indica a Cursor que active el servidor MCP mediante Docker cada vez que interactúes con él dentro del IDE.

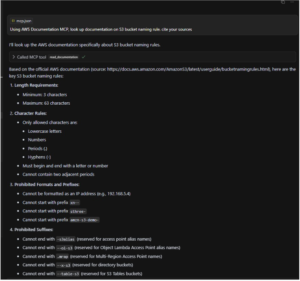

Paso 3: Usa la herramienta en Cursor

Una vez que la configuración esté en su lugar, abra Cursor y pida al agente algo como: «Con la documentación MCP de AWS, busque documentación sobre las reglas de nomenclatura de los buckets de S3. Cite sus fuentes». o «Recomendar contenido para la página https://docs.aws.amazon.com/AmazonS3/latest/userguide/bucketnamingrules.html» El cursor detectará que el aws-documentation-mcp-server está disponible y lo ejecutará automáticamente a través de Docker. Obtendrá el contenido de Markdown de los documentos relevantes de AWS y presentará una respuesta nítida y citable.

Figura 3: El usuario del cursor interactúa con la documentación de AWS MCP

Sin duda, MCP tiene el potencial de mejorar significativamente la forma en que los agentes de IA interactúan con los servicios de AWS, lo que facilita la consulta de datos, la administración de la infraestructura y la navegación por entornos de nube complejos a través del lenguaje natural. Aunque aún se encuentra en sus inicios, este enfoque sienta las bases para flujos de trabajo más intuitivos, automatizados e impulsados por agentes en todo el ecosistema de AWS.

Guía paso a paso: Integración del servidor Azure MCP con GitHub Copilot en VS Code

Paso 1: Requisitos previos

Asegúrese de tener lo siguiente:

- Código de Visual Studio: Instalado en su máquina.

- Copiloto de GitHub: Instalado y activado en VS Code.

- Chat de copiloto de GitHub: Instalado y activado en VS Code.

- Node.js: Instalado en su máquina

- Suscripción a Azure: una cuenta de Azure activa con los permisos adecuados.

Paso 2: Instalar el servidor Azure MCP manualmente

Cree una carpeta.vscode en el directorio del proyecto y añada mcp.json con la siguiente configuración: {«servers»: {«Azure MCP Server»: {«command»: «npx», «args»: [» -y», "@azure /mcp @latest «, «server», «start"]}}} Esta configuración configura el servidor MCP de Azure para que se inicie con el comando especificado.

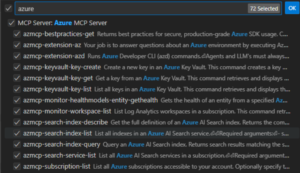

Paso 3: Probar el servidor Azure MCP

Abra GitHub Copilot en VS Code y cambiar al modo Agente. Deberías ver el servidor MCP de Azure con su lista de herramientas

Puede crear un chat en Copilot y enviar un mensaje. Por ejemplo: Devuelva las mejores prácticas para garantizar la seguridad en Azure Ejecutará una de las herramientas del MCP (azmcp-bestpractices-get) y la información estará en el chat.

Un protocolo, dos enfoques: comparación de las estrategias MCP de AWS y Azure

Si bien tanto Amazon Web Services (AWS) como Microsoft Azure invierten activamente en el futuro de los agentes de IA a través del MCP, sus estrategias adoptan formas muy diferentes. La visión compartida es clara: permitir que los agentes de IA interactúen con los servicios en la nube utilizando un lenguaje natural, sin necesidad de integraciones manuales ni conectores personalizados. Sin embargo, la ejecución, las herramientas y la experiencia de los desarrolladores varían considerablemente entre los dos gigantes de la nube.

Comparación de alto nivel

Característica: servidores MCP de AWS y enfoque de servidor MCP de Azure Varios servidores especializados Servidor unificado con herramientas modulares integradas Documentación Limitado; la orientación impulsada por la comunidad domina Limited; en su mayoría vinculada a GitHub Copilot Alcance de la integración Centrado en IDE; primeros experimentos independientes GitHub Copilot en VS Code; admite clientes personalizados Cobertura de servicio Herramientas detalladas por servicio de AWS Servidor único que cubre una gama de servicios de Azure Personalización Requiere secuencias de comandos personalizadas o el uso del SDK de Bedrock Modelo de complemento incorporado; manejo inteligente de errores y sugerencias Madurez de las herramientas Fase inicial, con implementaciones públicas de GitHub en fase inicial, estrechamente integradas en el ecosistema de Microsoft

Comprensión de las diferencias

AWS proporciona varios servidores MCP dedicados, cada uno adaptado a un servicio de AWS específico. Este enfoque modular brinda a los desarrolladores un control preciso sobre funciones como consultar la documentación de AWS, administrar las funciones de Lambda, analizar los costos o generar diagramas de infraestructura. Sin embargo, también significa que la configuración de varias integraciones puede requerir la puesta en marcha y el mantenimiento de varios puntos finales de MCP. Por el contrario, Azure ofrece un único servidor MCP que consolida varias herramientas. Este diseño unificado simplifica la implementación y reduce la sobrecarga de administrar muchos puntos finales. También incluye funciones como la traducción del lenguaje natural a una API, la función de finalización automática inteligente y un modelo de complementos que facilita la ampliación de la funcionalidad. Ambas plataformas aún se encuentran en las primeras etapas de integración. AWS admite integraciones de IDE limitadas (por ejemplo, con Cursor o VS Code), mientras que Azure se centra actualmente en el modo de agente de GitHub Copilot en VS Code. Los desarrolladores que prefieren la flexibilidad o que están creando agentes personalizados fuera del ecosistema de Microsoft pueden considerar que la configuración actual de Azure es limitante, aunque prometedora a largo plazo.

- AWS favorece la flexibilidad mediante la especialización, con servidores dedicados por tarea y servicio, ideales para arquitecturas modulares y flujos de trabajo de agentes personalizados.

- Azure se centra en la simplicidad y la cohesión, y ofrece una amplia cobertura a través de una interfaz unificada, diseñada para funcionar sin problemas con las herramientas de Microsoft.

- Ambos ecosistemas aún están madurando, con un gran potencial, pero con un soporte listo para usar limitado para los flujos de trabajo que no están basados en IDE.

Al final, la elección puede depender de la cadena de herramientas existente y de las preferencias del desarrollador. Si necesita un control detallado de servicios específicos de AWS, el ecosistema MCP de AWS es exhaustivo. Si prefiere la simplicidad, una interfaz centralizada y la integración nativa con las herramientas de Microsoft, el servidor MCP de Azure es un buen candidato. A medida que el protocolo MCP evoluciona, ambos proveedores de nube están creando la infraestructura básica para una nueva era de computación en la nube basada en agentes nativos, en la que la IA no solo funcione en la nube, sino que también trabaje con ella.

Reflexiones finales

El protocolo MCP representa un paso importante hacia la integración de los agentes de IA con los servicios en la nube de una manera más práctica. Tanto AWS como Azure están desarrollando activamente sus estrategias de MCP con diferentes enfoques. Mientras que AWS se centra en servidores especializados para servicios individuales, ofreciendo un control granular, Azure apunta a un servidor unificado con herramientas integradas, priorizando la simplicidad dentro de su ecosistema. El futuro de MCP tiene un inmenso potencial para automatizar los flujos de trabajo en la nube, reducir la fricción de DevOps y permitir las interacciones en lenguaje natural con entornos de nube complejos. A medida que la tecnología madure y la documentación mejore, podemos esperar una adopción más amplia y el desarrollo de flujos de trabajo más sofisticados impulsados por agentes.

.png)